ChatGPT induit un avocat américain en erreur

Un avocat new-yorkais a été confondu par le juge en charge du dossier pour avoir cité dans son mémoire juridique des cas qui n’existaient pas. Il a reconnu avoir utilisé ChatGPT et lui avoir demandé si ses informations étaient vraies.

Ce fait divers insolite a fait le tour des médias américains et a suscité de nombreuses réactions dans le monde juridique. Comment un avocat professionnel a-t-il pu se laisser berner par un générateur de texte basé sur l’intelligence artificielle ? Quelles sont les conséquences de son acte pour sa carrière et pour la crédibilité de la justice ? Et surtout, comment éviter que ce genre de situation ne se reproduise à l’avenir ?

Dans cet article, nous allons revenir sur les faits, analyser les causes et les effets de cette affaire, et proposer des pistes de réflexion pour prévenir les risques liés à l’utilisation des outils d’IA dans le domaine juridique.

Les faits

L’affaire concerne un procès opposant une compagnie aérienne à un passager qui réclame des dommages et intérêts pour avoir été victime d’une intoxication alimentaire lors d’un vol. L’avocat du plaignant, Me John Smith, a rédigé son mémoire juridique en se basant sur les informations fournies par son client et en effectuant des recherches sur Internet.

Jusque-là, rien d’anormal. Sauf que Me Smith a eu recours à un outil d’IA nommé ChatGPT, qui permet de générer du texte à partir de mots-clés ou de phrases. Il a ainsi demandé à ChatGPT de lui fournir des exemples de jurisprudence en rapport avec son affaire, en lui précisant le pays, le domaine et le type de litige.

ChatGPT lui a alors renvoyé une liste de cas fictifs, inventés de toutes pièces par l’algorithme, mais présentés comme réels et crédibles. Me Smith, sans vérifier la véracité des sources, les a repris dans son mémoire juridique et les a cités comme des arguments en faveur de son client.

Le problème, c’est que les avocats de la compagnie aérienne ont rapidement détecté la supercherie en consultant les bases de données juridiques officielles. Ils ont alors alerté le juge, qui a convoqué Me Smith pour lui demander des explications.

Face au magistrat, l’avocat a avoué avoir utilisé ChatGPT et lui avoir fait confiance. Il a affirmé qu’il ne savait pas que l’outil pouvait générer des cas fictifs et qu’il pensait que ses informations étaient vraies. Il a présenté ses excuses au juge et à la partie adverse, et a reconnu sa faute professionnelle.

Les causes

Comment expliquer qu’un avocat expérimenté se soit laissé tromper par un générateur de texte ? Plusieurs facteurs peuvent être invoqués :

- La méconnaissance des outils d’IA : Me Smith n’était pas familier avec le fonctionnement de ChatGPT ni avec ses limites. Il ignorait que l’outil pouvait produire du contenu faux ou trompeur, et qu’il fallait toujours vérifier ses sources avant de les utiliser.

- La facilité d’accès aux outils d’IA : ChatGPT est un outil gratuit et facile à utiliser, qui ne nécessite pas de compétences particulières ni d’autorisation préalable. Il suffit de taper une requête et d’obtenir une réponse en quelques secondes. Cela peut inciter certains utilisateurs à se fier aveuglément aux résultats sans les remettre en question.

- La pression du temps : Me Smith était sous le coup d’une deadline pour rendre son mémoire juridique. Il n’avait pas le temps ni les moyens de faire des recherches approfondies sur la jurisprudence. Il a donc opté pour la solution la plus rapide et la plus simple, sans se soucier de la qualité ni de la fiabilité du contenu.

- La tentation de l’innovation : Me Smith voulait se démarquer de ses confrères et impressionner le juge en utilisant un outil moderne et innovant. Il pensait que ChatGPT lui donnerait un avantage concurrentiel et lui permettrait de trouver des arguments originaux et pertinents. Il a donc succombé à la tentation de l’innovation, sans mesurer les risques ni les conséquences.

Les effets

Quelles sont les répercussions de cette affaire pour Me Smith et pour le monde juridique en général ?

- Pour Me Smith, les conséquences sont lourdes. Il risque une sanction disciplinaire de la part du barreau, qui peut aller du blâme à la radiation. Il risque également une sanction pénale pour faux et usage de faux, qui peut entraîner une amende ou une peine de prison. Il risque enfin une sanction civile pour préjudice causé à son client, qui peut lui réclamer des dommages et intérêts. Sans compter la perte de crédibilité et de réputation auprès de ses pairs et de ses clients potentiels.

- Pour le monde juridique, l’affaire soulève des questions éthiques et déontologiques sur l’utilisation des outils d’IA dans le domaine du droit. Faut-il encadrer l’accès et l’usage de ces outils ? Faut-il imposer des normes de qualité et de vérification du contenu ? Faut-il former les professionnels du droit aux enjeux et aux risques liés à l’IA ? Faut-il sensibiliser le public aux dangers de la désinformation et de la manipulation ?

Les pistes

Face à ce phénomène nouveau et inquiétant, il est nécessaire de réfléchir à des solutions pour prévenir les abus et les erreurs liés à l’utilisation des outils d’IA dans le domaine juridique. Voici quelques pistes possibles :

- Développer une culture du doute et de l’esprit critique : il faut apprendre à ne pas se fier aveuglément aux résultats fournis par les outils d’IA, mais à les vérifier, les comparer, les croiser avec d’autres sources. Il faut également être conscient des biais, des lacunes et des limites de ces outils, qui ne sont pas infaillibles ni neutres.

- Renforcer la formation et l’information : il faut former les professionnels du droit aux principes, aux fonctionnalités et aux risques des outils d’IA, afin qu’ils puissent les utiliser à bon escient et en toute responsabilité. Il faut également informer le public sur les enjeux et les dangers de l’IA, afin qu’il puisse exercer son droit à l’information et à la transparence.

- Instaurer un cadre juridique et éthique : il faut définir des règles claires et communes sur l’accès, l’usage, la qualité, la traçabilité et la responsabilité des outils d’IA dans le domaine juridique. Il faut également veiller au respect des principes fondamentaux du droit, tels que le contradictoire, le droit à la preuve, le droit à un procès équitable.

Conclusion

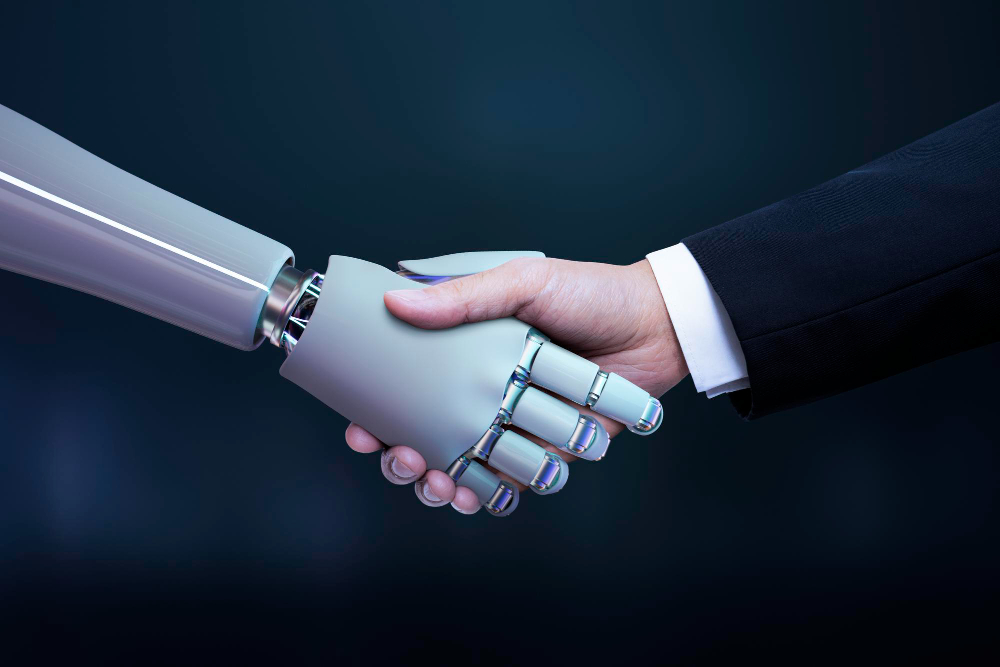

L’affaire du mémoire juridique truqué par ChatGPT est un exemple frappant des opportunités mais aussi des dangers que représentent les outils d’IA dans le domaine juridique. Ces outils peuvent être utiles pour faciliter le travail des professionnels du droit, mais ils peuvent aussi être détournés ou mal utilisés pour tromper ou manipuler.

Il est donc essentiel de développer une approche critique, éthique et responsable de ces outils, en s’appuyant sur une formation, une information, une régulation et une vigilance constantes.

L’IA n’est pas une fin en soi, mais un moyen au service du droit. Elle doit être utilisée avec discernement, prudence et respect.

( Me. Smith : nom d’emprunt)